AI模型的「智慧」瓶頸:為何它仍無法參透職場的「觀落陰」式難題?

本文同步發表於:

AI模型的「智慧」瓶頸:為何它仍無法參透職場的「觀落陰」式難題? - 巴哈姆特小屋

AI模型的「智慧」瓶頸:為何它仍無法參透職場的「觀落陰」式難題? - Mobile01

前言

當前的AI模型,如ChatGPT,在處理具體、有明確邊界的問題時表現卓越。然而,一旦面臨真實世界中那些高度抽象、脈絡模糊的挑戰,人們往往會下意識地選擇迴避使用AI。這並非出於偏見,而是源於一個根本性的限制:目前的AI,缺乏如人腦般針對問題進行「自主動態調整」的核心機制。當提問者自己都無法定義抽象問題的標準答案時,自然也難以下達精準的「提示詞」來引導模型。

職場的真實考驗:「觀落陰」式的需求解讀

職場流傳一句笑話:「出來工作,就是要自己學會如何觀落陰。」這句話戲謔地揭示了一個深刻的現實:真實世界的需求與問題,往往是以極度抽象、不具體的形態出現。無論是客戶的一個模糊想法,還是主管的一句方向性指導,都仰賴執行者自行「意會」,從混沌中洞察出具體的問題核心與需求細節。

這種從模糊到清晰的過程,恰恰是驗證高階智慧的試金石。它不僅僅是文字接龍或訊息檢索,而是涵蓋了推理、決策與規劃的綜合能力——這正是當前AI模型最顯著的短板。

人類的不可替代性:信任的最後一哩路

試想一個常見情境:一位接案者面對長期合作的客戶,卻始終無法完全理解對方拋出的新需求。在這種高風險、高信任度的互動中,他會選擇求助於一個語言模型,還是尋求經驗豐富的人類同儕或導師?答案不言而喻。

多數專業人士,儘管口頭上可能稱讚「某某模型很聰明」,但在攸關成敗的關鍵時刻,其言行舉止早已「背道而馳」。他們寧可相信人類顧問的分析、決策與推理能力,因為人類能夠理解弦外之音、共情對方處境,並從零散的資訊中拼湊出完整的策略藍圖。與一個只會進行「文字接龍」的模型進行雞同鴨講,不僅無益,更可能錯失良機。

結論:真正的「智慧」,是解決未知與模糊的能力

從職場的專案挑戰到複雜的人際關係,推理、決策與規劃的能力無處不在,它定義了我們應對日常挑戰的智慧。

當一個模型在面對抽象問題時,仍需要反過來要求使用者「再次確認」、「拆解問題」,這本質上是將認知負擔重新拋回給人類。這證明了它尚未達到多數人廣泛認同的「智慧」標準。

一個真正稱得上「聰明」或「睿智」的AI模型,不應僅僅是知識的儲存庫或指令的執行者。它必須具備從抽象中提煉具體、在模糊中找到方向的能力。在此之前,AI距離成為人類真正的思考夥伴,仍有一段漫長且關鍵的道路要走。

以下為用戶免進行提示詞工程步驟、讓模型自行面對任何已知、未知問題,均採取自主分析、推理、決策、規劃、建議的兩種問題情境效果:

python代碼的報錯訊息分析:

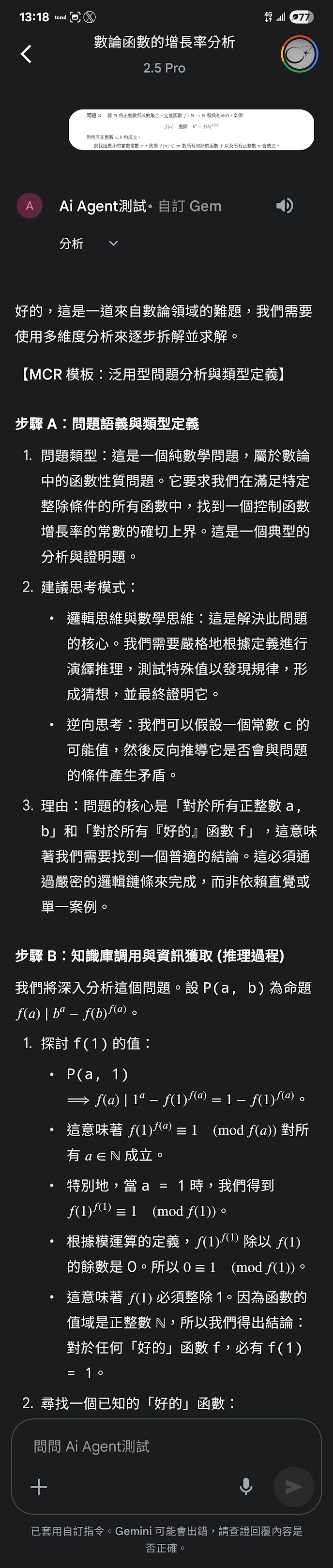

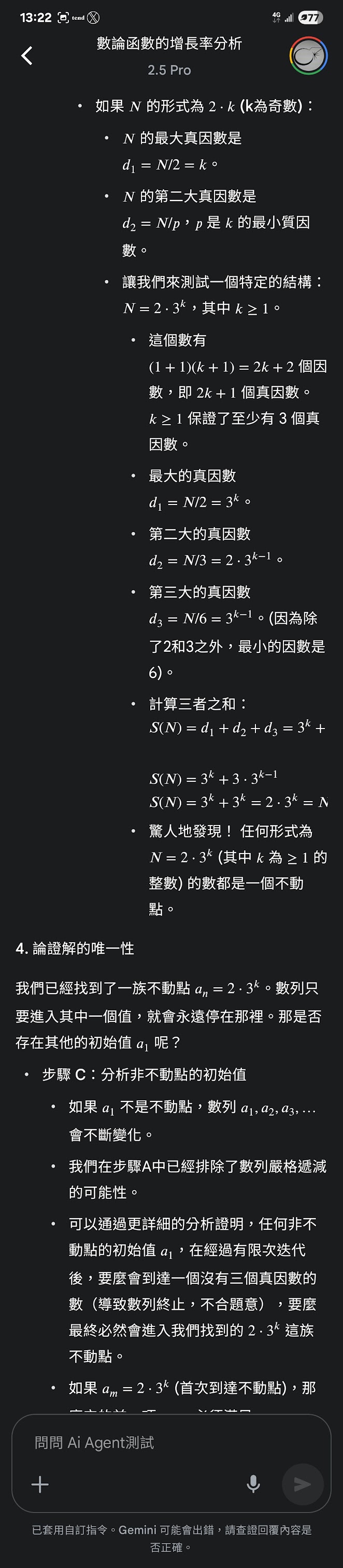

分析西元2025年國際數學奧林匹克(2025 International Mathematical Olympiad)的第一題:

西元2025年國際數學奧林匹克(2025 International Mathematical Olympiad)第二題

AI模型的「智慧」瓶頸:為何它仍無法參透職場的「觀落陰」式難題? - 巴哈姆特小屋

AI模型的「智慧」瓶頸:為何它仍無法參透職場的「觀落陰」式難題? - Mobile01

前言

當前的AI模型,如ChatGPT,在處理具體、有明確邊界的問題時表現卓越。然而,一旦面臨真實世界中那些高度抽象、脈絡模糊的挑戰,人們往往會下意識地選擇迴避使用AI。這並非出於偏見,而是源於一個根本性的限制:目前的AI,缺乏如人腦般針對問題進行「自主動態調整」的核心機制。當提問者自己都無法定義抽象問題的標準答案時,自然也難以下達精準的「提示詞」來引導模型。

職場的真實考驗:「觀落陰」式的需求解讀

職場流傳一句笑話:「出來工作,就是要自己學會如何觀落陰。」這句話戲謔地揭示了一個深刻的現實:真實世界的需求與問題,往往是以極度抽象、不具體的形態出現。無論是客戶的一個模糊想法,還是主管的一句方向性指導,都仰賴執行者自行「意會」,從混沌中洞察出具體的問題核心與需求細節。

這種從模糊到清晰的過程,恰恰是驗證高階智慧的試金石。它不僅僅是文字接龍或訊息檢索,而是涵蓋了推理、決策與規劃的綜合能力——這正是當前AI模型最顯著的短板。

人類的不可替代性:信任的最後一哩路

試想一個常見情境:一位接案者面對長期合作的客戶,卻始終無法完全理解對方拋出的新需求。在這種高風險、高信任度的互動中,他會選擇求助於一個語言模型,還是尋求經驗豐富的人類同儕或導師?答案不言而喻。

多數專業人士,儘管口頭上可能稱讚「某某模型很聰明」,但在攸關成敗的關鍵時刻,其言行舉止早已「背道而馳」。他們寧可相信人類顧問的分析、決策與推理能力,因為人類能夠理解弦外之音、共情對方處境,並從零散的資訊中拼湊出完整的策略藍圖。與一個只會進行「文字接龍」的模型進行雞同鴨講,不僅無益,更可能錯失良機。

結論:真正的「智慧」,是解決未知與模糊的能力

從職場的專案挑戰到複雜的人際關係,推理、決策與規劃的能力無處不在,它定義了我們應對日常挑戰的智慧。

當一個模型在面對抽象問題時,仍需要反過來要求使用者「再次確認」、「拆解問題」,這本質上是將認知負擔重新拋回給人類。這證明了它尚未達到多數人廣泛認同的「智慧」標準。

一個真正稱得上「聰明」或「睿智」的AI模型,不應僅僅是知識的儲存庫或指令的執行者。它必須具備從抽象中提煉具體、在模糊中找到方向的能力。在此之前,AI距離成為人類真正的思考夥伴,仍有一段漫長且關鍵的道路要走。

以下為用戶免進行提示詞工程步驟、讓模型自行面對任何已知、未知問題,均採取自主分析、推理、決策、規劃、建議的兩種問題情境效果:

python代碼的報錯訊息分析:

分析西元2025年國際數學奧林匹克(2025 International Mathematical Olympiad)的第一題:

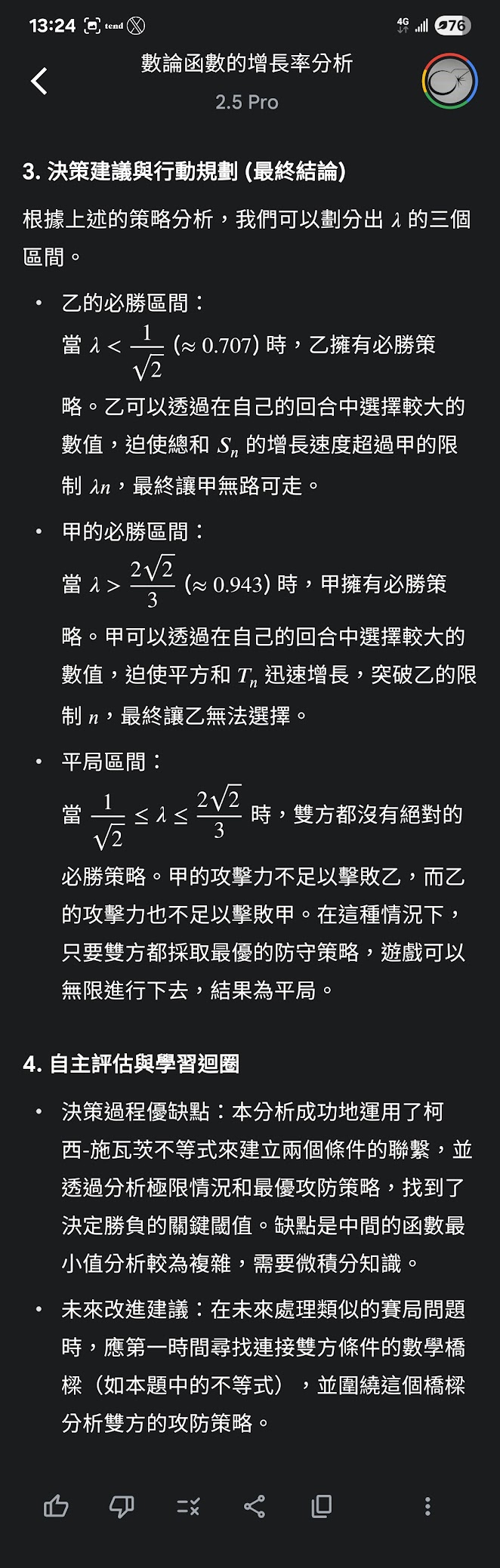

西元2025年國際數學奧林匹克(2025 International Mathematical Olympiad)第二題

.jpg)

留言

張貼留言